Un nouveau logiciel prévoit une défaillance de l’intelligence artificielle

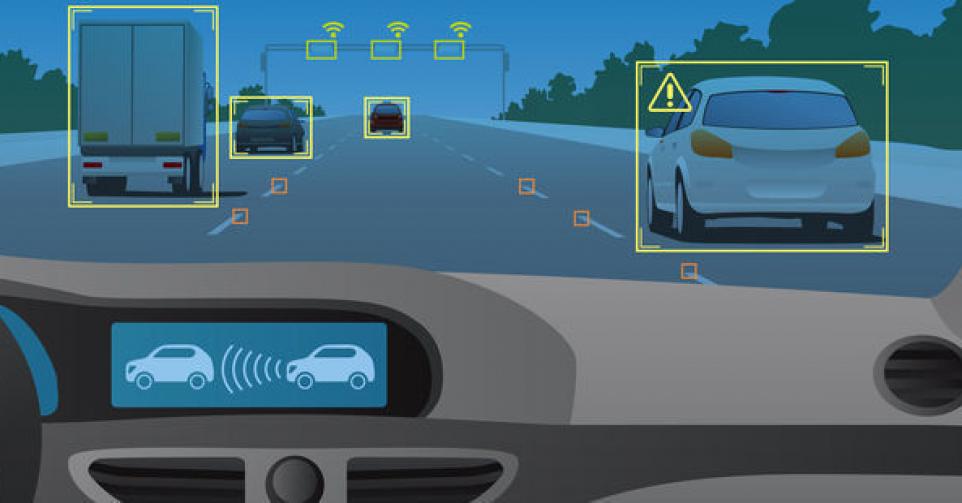

Un logiciel développé à l’université de Columbia est capable de tester automatiquement le bon fonctionnement des systèmes de reconnaissance de modèles pour voitures autonomes. Cela a déjà permis de découvrir des milliers d’erreurs qui n’avaient précédemment encore jamais été détectées.

Si on veut mettre en circulation d’ici dix ans des voitures autonomes, il sera crucial qu’on puisse faire confiance toujours et à cent pour cent à leur système d’identification de modèles. Il n’est cependant pas évident de tester ces systèmes pour y découvrir des bugs éventuels: il n’y a en effet pas de code qu’on puisse simplement ‘debugger’.

Problème de boîte noire

Ces systèmes utilisent en effet l’apprentissage profond (‘deep learning’) pour extraire des modèles (gabarits) de grandes quantités de données et ainsi s’améliorer. La solution qui en résulte, semble souvent fonctionner extrêmement bien, mais la manière dont cela se passe précisément, nous échappe totalement. Il nous est donc malaisé de leur faire confiance en toutes circonstances. C’est ainsi que les voitures autonomes peuvent être trompées par des panneaux routiers manipulés, ce qui les incite à prendre de mauvaises décisions.

Jusqu’à présent, ces panneaux manipulés étaient créés manuellement et sciemment par des personnes en vue de défier le système AI. Des chercheurs de l’université de Columbia ont à présent trouvé une façon de tester les systèmes équipant les voitures autonomes d’une manière consistante, à savoir mettre à l’épreuve l’intelligence artificielle elle-même.

Ils ont à cette fin mis au point DeepXplore qui se base sur des illustrations de test à partir desquelles un système de ‘deep learning’ déduit des modèles. Il s’agit ensuite de manipuler progressivement ces images jusqu’à engendrer des décisions erronées.

Prévoir quand l’AI ratera un virage

Un exemple: un système AI voit apparaître la photo d’une route tournant vers la gauche et en déduit que la voiture autonome doit obliquer à gauche. DeepXplore assombrit ensuite progressivement la photo jusqu’au moment où le système AI génère une décision contraire. Si le système AI demande subitement à la voiture d’obliquer vers la droite, celle-ci va heurter le rail de sécurité. Le système sait donc alors que dans ces circonstances, il doit mieux s’entraîner, afin de bien interpréter aussi les photos plus sombres.

DeepXplore est conçu de manière à traiter les photos jusqu’à ce que le système AI prenne le plus de décisions contradictoires possibles. Il peut ainsi aussi simuler la présence de tellement d’impuretés sur une caméra de la voiture que le système AI se trompe.

En testant leur software sur quinze réseaux neuraux existants, dont le réseau Dave 2 de Nvidia pour voitures autonomes, les chercheurs ont découvert des milliers de bugs qui n’avaient précédemment encore jamais été détectés.

DeepXplore est aussi à même de ré-entraîner ensuite les modèles d’apprentissage profond et d’améliorer ainsi leur degré de précision de trois pour cent à 99 pour cent. Les chercheurs présenteront leurs résultats dimanche à Shanghai. Leur logiciel open-source a déjà été mis à disposition d’autres chercheurs souhaitant tester leur propre système AI.

Vous avez repéré une erreur ou disposez de plus d’infos? Signalez-le ici